每经记者 宋欣悦 每经裁剪 兰素英

2月6日,据外媒报说念,李飞飞等斯坦福大学和华盛顿大学的接洽东说念主员以不到50好意思元的用度,使用了16张英伟达H100 GPU,耗时26分钟就完成了磨真金不怕火,告捷“打造”出了一个名为s1-32B的东说念主工智能推理模子。

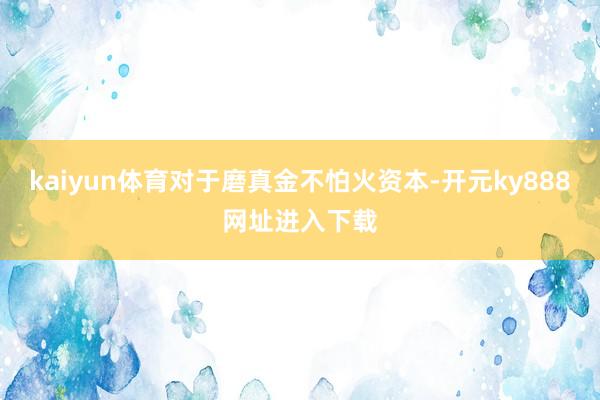

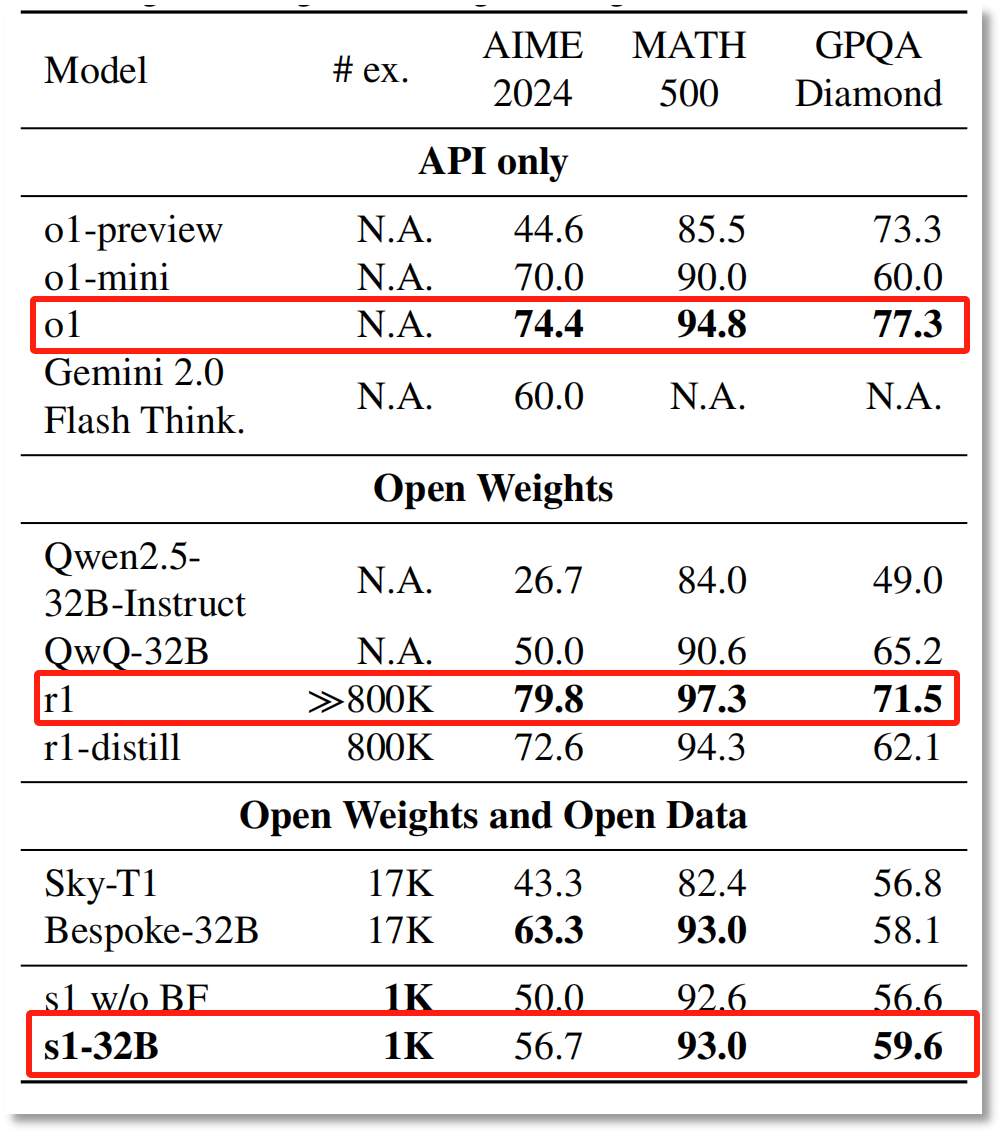

凭证李飞飞等东说念主的接洽论文《s1: Simple test-time scaling》,该模子在数学和编码智力测试中的施展,与OpenAI的o1和DeepSeek的R1等顶端推理模子不相高下,在竞赛数常识题上的施展更是比o1-preview最初27%。

凭借低资本、高效用,s1模子成为继“AI界价钱屠户”DeepSeek之后再次激勉科技界热议的话题。

但s1推理模子的资本真实独一50好意思元吗?其性能是否真有描写的那么出色?在“白菜价”的背后,李飞飞团队又有哪些探索?

针对资本问题,复旦大学打算机学院副教师、博士生郑骁庆在剿袭《逐日经济新闻》记者采访时指出,“像DeepSeek草率近似的公司,在寻找灵验的整合惩办有谋划时,需要进行多半的前期接洽与消融践诺。”这意味着前期是需要多半“烧钱”的。

图片着手:论文《s1: Simple test-time scaling》

图片着手:论文《s1: Simple test-time scaling》

据报说念,李飞飞等斯坦福大学和华盛顿大学的接洽东说念主员以不到50好意思元的用度,使用了16张英伟达H100 GPU,耗时26分钟就完成了模子s1-32B的磨真金不怕火。

参与该项筹备斯坦福大学接洽员尼克拉斯·穆宁霍夫(Niklas Muennighoff)更是暗意,如今,只消约20好意思元就能租到所需的打算资源。

但是,对于磨真金不怕火资本,有几点需要明确。

起始,模子s1-32B的打造并非是从零运转,而是基于现成的、预磨真金不怕火的模子(阿里通义千问Qwen2.5-32B-Instruct)进行监督微调。而微调一个模子和从零运转磨真金不怕火一个模子的资本是无法等量都不雅的。

其次,50好意思元是否包含了其他数据、耕种、消融践诺等用度,还要打一个问号。正如DeepSeek-V3不到600万好意思元的磨真金不怕火资本,内容上也只包括了磨真金不怕火时的GPU算力用度。

郑骁庆向每经记者暗意,“像DeepSeek草率近似的公司,在寻找灵验的整合惩办有谋划时,需要进行多半的前期接洽与消融践诺。”

而消融践诺就意味着,前期是需要多半“烧钱”的。

AI数据公司Databricks接洽员奥马尔·哈塔布(Omar Khattab)评价称,(李飞飞团队的)论文似乎是对于Qwen模子的某种发现。

图片着手:X

图片着手:X

谷歌DeepMind资深接洽员Wenhu Chen相通暗意,“着实神奇的是Qwen模子。咱们尝试过把基座模子换成其他模子,用相通的数据去磨真金不怕火,但最终并不可达到这样好的闭幕。”

也即是说,s1-32B是站在了“巨东说念主肩膀”上,且50好意思元的资本也并莫得涵盖Qwen模子的磨真金不怕火用度。

李飞飞团队发表的论文提到,凭证Qwen2.5-32B-Instruct进行微调的s1-32B模子,在数学和编码智力测试中的施展,与OpenAI的o1和DeepSeek的R1等顶端推理模子不相高下,在竞赛数常识题上的施展更是比o1-preview最初27%。

图片着手:论文《s1: Simple test-time scaling》

图片着手:论文《s1: Simple test-time scaling》

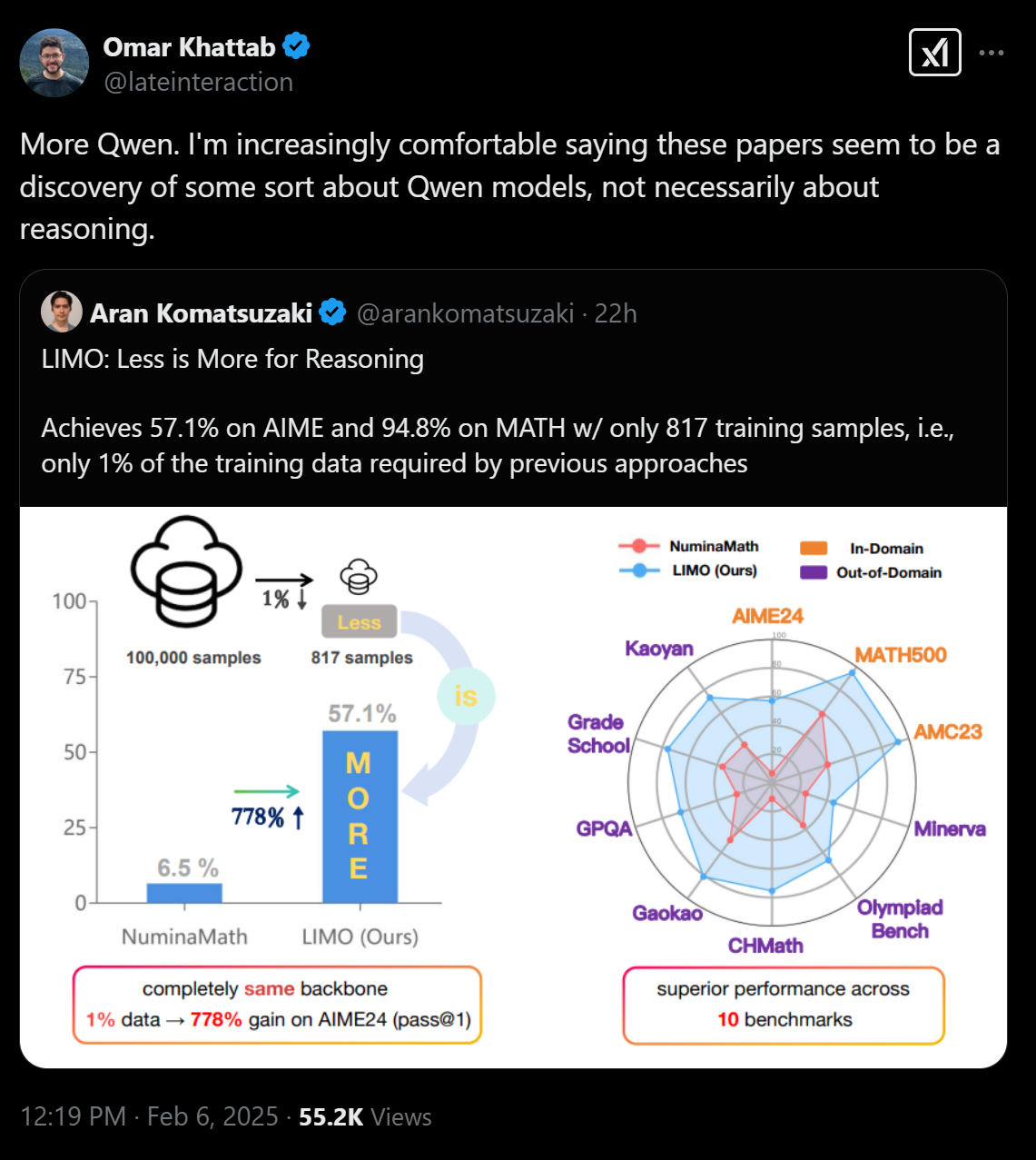

此外,接洽闭幕线路,s1-32B是样本效率最高的绽开数据推理模子,施展较着优于其基座模子(Qwen2.5-32B-Instruct)以及OpenAI的推理模子o1-preview。

事实上,s1-32B只可在特定的测试集上卓越o1-preview,且并莫得卓越“满血版”o1和DeepSeek-R1。

图片着手:论文《s1: Simple test-time scaling》

图片着手:论文《s1: Simple test-time scaling》

接洽闭幕线路,在AIME 2024和MATH 500两个测试联结,s1-32B卓越了o1-preview,但无论在哪个测试集,s1-32B都莫得卓越“满血版”o1郑再版DeepSeek-R1。

测试时拓展:多动脑多查验

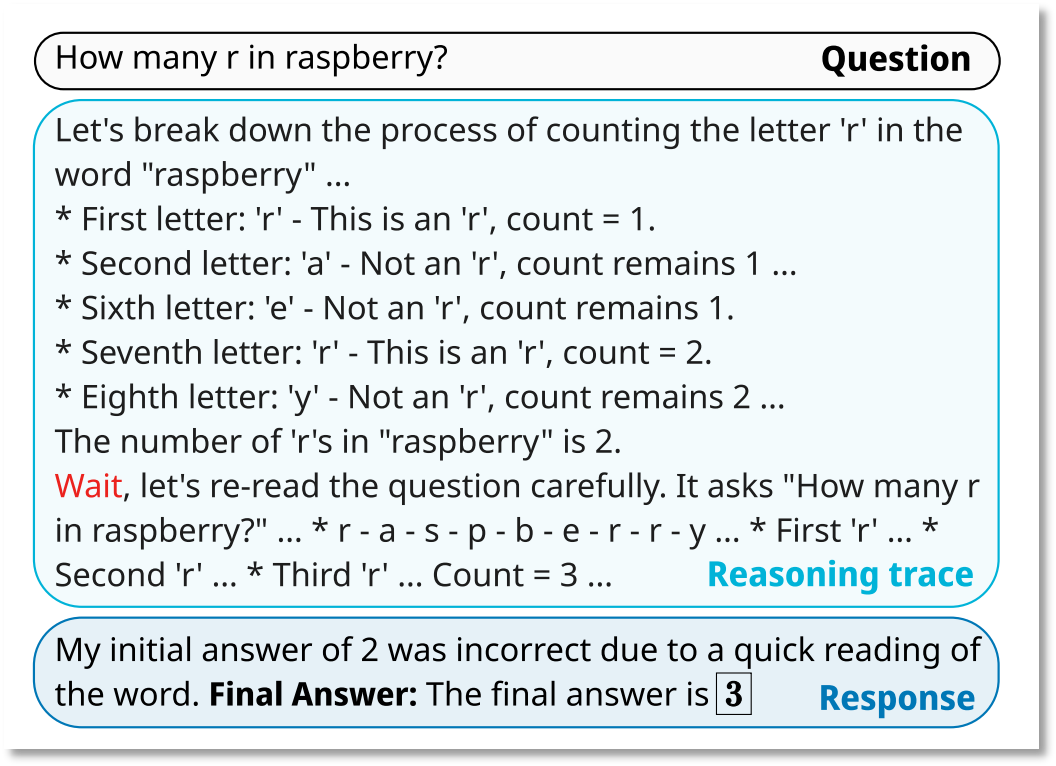

事实上,李飞飞团队论文的中枢也并不在于若何“卷”模子价钱,而是接洽若何以最浅易的表情已毕“测试时拓展”(test-time scaling)。

测试时膨大是一种在模子推理阶段通过多步推理来提高模子性能的时刻。具体来说,接洽团队通过预算强制,阻抑模子不错“念念考”多永劫候或进行若干步操作。若是模子过早扫尾推理,系统会饱读吹模子蔓延念念考时候,确保其充分接洽问题。这也就意味着,模子在推理时会进行屡次推理迭代,并渐渐优化推理闭幕,最毕生成高质料的谜底。

举例,当被问到“raspberry”中有几个“r”时,模子起始进行了初步推理,并得出了作假的初步闭幕:有2个r。但推理经过并莫得就此扫尾,模子又再行进行推理,优化了前次报告的闭幕,输出了最终的谜底:3个r。

图片着手:论文《s1: Simple test-time scaling》

图片着手:论文《s1: Simple test-time scaling》

OpenAI的o1系列模子即是一个典型的例子,展现了测试时拓展在模子性能进步上的后劲。

微软CEO萨提亚·纳德拉(Satya Nadella)曾暗意,咱们正在见证一种新的范围划定(Scaling Law)的出现——模子效率与测试时候或推理时候打算相干。

高质料数据集s1K:数据真金不怕火金术

此外,李飞飞接洽团队还从16个着手齐集了59029说念高质料题目,包括数学竞赛问题、博士级别的科常识题、奥林匹克竞赛问题等,并通过三个瓜代进行考据:难度、各样性和质料。

通过过滤,接洽团队最终获得了包含1000个样本的s1K数据集,数据集心事几何、数论、量子力学等50个界限,而况每个问题都配有从Google Gemini 2.0 Flash Thinking Experimental看成“教师模子”蒸馏而来的的谜底和推理轨迹。

这个数据集的构建基于三个枢纽瓜代:难度、各样性和质料。

高质料的数据集,极大镌汰了s1-32B模子的磨真金不怕火资本。

复旦大学打算机学院副教师、博士生郑骁庆在剿袭每经记者时暗意,大范围的数据可能不会成为下一步碾儿家争夺的战场,其资本和产出之间的比例在缓缓压缩,而高质料数据的微解救强化学习异日将会有更多的参加。

海量资讯、精确解读,尽在新浪财经APP

海量资讯、精确解读,尽在新浪财经APP

背负裁剪:王若云 kaiyun体育